La investigación titulada «Space‐time autoregressive estimation and prediction with missing data based on Kalman filtering» fue publicada en la prestigiosa revista científica “Environmetrics”.

El trabajo de investigación científica fue desarrollado por el alumno de Magíster en Estadística, del Departamento de Estadística de la Universidad de Concepción, Leonardo Padilla S. junto a su director de proyecto de tesis profesor Dr. Bernardo Lagos-Álvarez y surge a partir de la pérdida de información que se produce en el uso de tecnologías aplicadas a pronósticos medioambientales, las cuales, al no ser perfectas, pueden verse afectadas por diversos eventos y provocar pérdida de información.

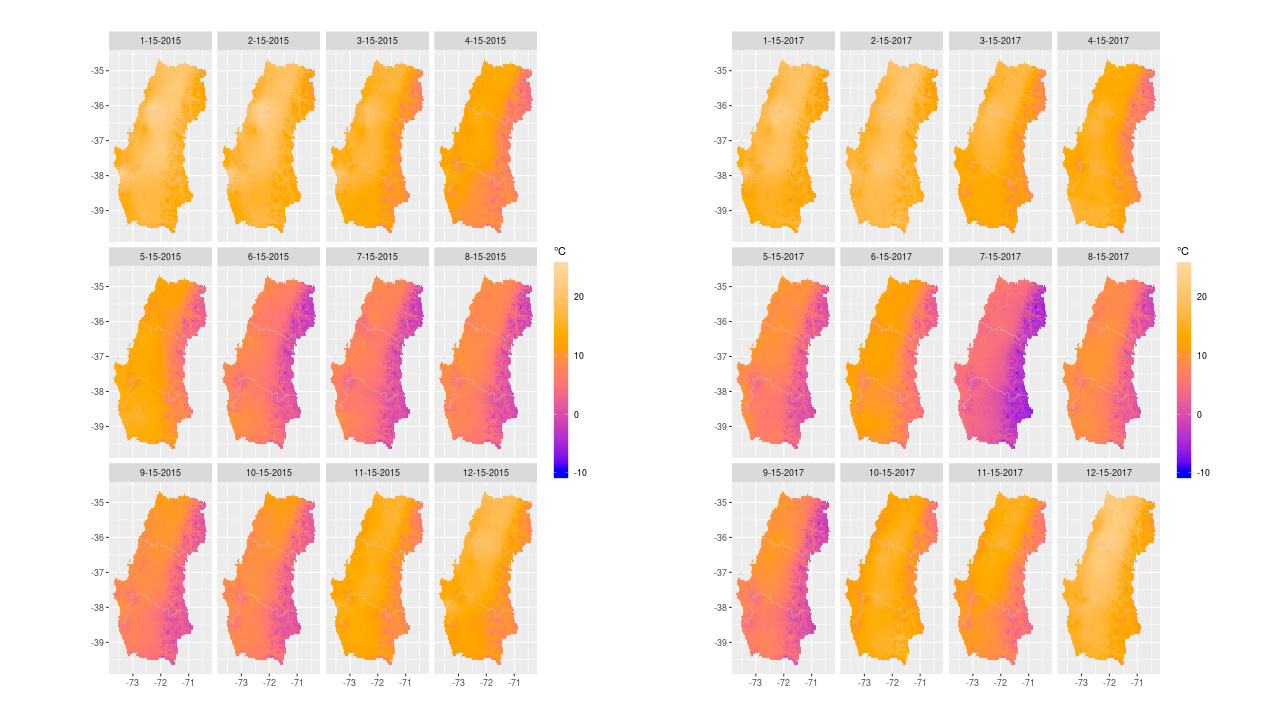

Con varios fenómenos ambientales de interés, tanto para la comunidad científica como para el sector industrial, tales como los movimientos de fluidos, en particular recursos hídricos, velocidad y dirección del viento, temperatura del aire o de la tierra (incluyendo océanos), y radiación solar entre otros, los especialistas buscan tratar de modelar para así poder predecirlos de la manera más confiable posible.

En el caso de la industria, la modelación de estos atributos conduce a una optimización de recursos, generando un impacto desde el punto de vista de la rentabilidad de proyectos. “Estos fenómenos son usualmente caracterizados por su variabilidad tanto espacial, ya que sus propiedades van variando dependiendo de la localidad geográfica en la que se esté midiendo, como temporal, la cual también dependen de las fechas en la que se registran los datos”, comenta el Dr. Lagos.

De acá surge la iniciativa de invertir en la implementación de tecnologías que ayuden en la recopilación de datos: por ejemplo, las estaciones meteorológicas, las cuales reúnen periódicamente los registros asociados a estos fenómenos. Sin embargo, como la confiabilidad de las tecnologías no es constante al 100%, es decir son imperfectas, éstas son susceptibles a cualquier efecto ajeno que influya o, en el peor de los casos, impida la recopilación adecuada de los datos.

Bajo este escenario de pérdida de información es que surge la idea de implementar procedimientos estadísticos que nos permitan modelar este tipo de información de la mejor manera posible. “Desde el punto de vista del big data, el filtro de Kalman es un algoritmo que nos permite manejar un gran flujo de información en tiempo real y, por cada instante de tiempo, ir realizando inferencia estadística mediante técnicas de regresión avanzadas y, sin importar cuánta información falte en cada momento que llegue nueva información. El modelo se encargará de realizar la mejor predicción posible usando la información que haya disponible”, explica el Dr. Lagos.

La investigación se publicó en la revista “Environmetrics” y se puede revisar en este link.